El algoritmo de YouTube te empuja al entretenimiento si mirás demasiada política

Un nuevo estudio revela que el algoritmo de YouTube redirige a los usuarios hacia videos más alegres y virales cuando detecta un alto consumo de contenido político. ¿Control emocional o estrategia de retención?

¿Qué está pasando?

Un estudio reciente detectó que el algoritmo de YouTube tiende a redirigir a los usuarios desde contenidos políticos hacia videos más livianos, centrados en el entretenimiento, el humor o los tutoriales.

Este patrón se repite especialmente cuando los usuarios pasan mucho tiempo viendo videos sobre política, economía o temas ideológicos intensos.

La hipótesis más fuerte: YouTube busca equilibrar la experiencia emocional del usuario para mantenerlo más tiempo en la plataforma, sin agotarlo ni saturarlo.

¿Qué dice el estudio?

La investigación, difundida por medios como Fast Company y plataformas especializadas en IA y redes sociales, se centró en el análisis de YouTube Shorts, aunque el patrón es extrapolable al algoritmo general de recomendaciones.

“Tras consumir varios videos de política, los usuarios son empujados hacia videos de animales, recetas, comedia o curiosidades”, explican los autores.

Este fenómeno no parece ser censura, sino una estrategia de optimización algorítmica basada en retención y estado emocional.

¿El fin del túnel de radicalización?

Durante años, se acusó a YouTube de alimentar la radicalización política a través de un “túnel algorítmico” que llevaba a los usuarios de videos moderados a contenidos extremos.

Sin embargo, investigaciones más recientes —como las impulsadas por Mozilla o académicos de UC Davis y Princeton— muestran otra cara:

El algoritmo no te radicaliza, sino que te regula.

En lugar de profundizar en una sola línea de contenido, tiende a mezclar experiencias para evitar la fatiga cognitiva.

¿Cómo funciona?

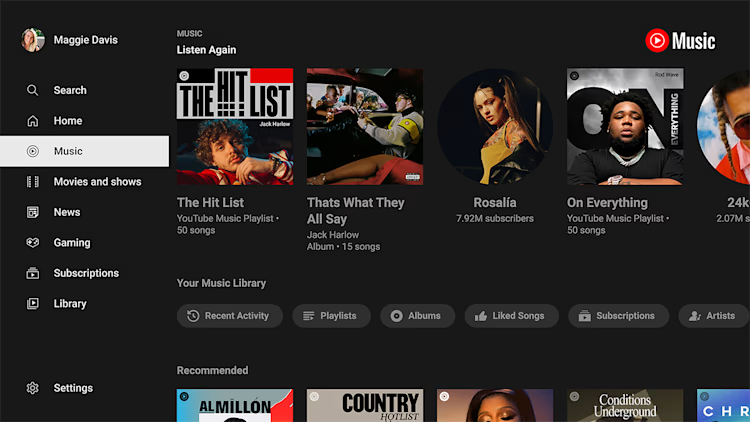

Los sistemas de recomendación de YouTube analizan variables como:

-

Tiempo de visualización

-

Interacción (likes, comentarios, suscripciones)

-

Reacciones fisiológicas estimadas (basadas en patrones de navegación)

Cuando detectan un exceso de carga emocional —como puede suceder con temas políticos o sociales complejos— inician una transición hacia contenido más emocionalmente neutro o placentero: cocina, mascotas, música, desafíos virales, viajes.

¿Qué implica esto?

-

YouTube no te censura, pero sí decide qué mostrarte en base a lo que considera más “saludable” para tu tiempo en pantalla.

-

El algoritmo actúa como un curador emocional, que alterna tensión con alivio para que no cierres la app.

-

Consumir solo política puede llevarte, sin darte cuenta, a mirar un compilado de fails de gatos.

Lo que parecía una plataforma neutra es, en realidad, una experiencia diseñada para gestionar tus emociones.

YouTube no te dice qué pensar, pero sí qué mirar a continuación. Y si consumís demasiada política, lo más probable es que termine ofreciéndote un video de perritos bailando salsa.

¿Es manipulación? ¿Es cuidado digital? ¿O simplemente negocios?